Untuk memastikan situs webmu mudah ditemukan oleh mesin pencari, kamu perlu mengoptimalkan keberadaan website crawlers. Di balik layar, website crawlers inilah yang menentukan seberapa baik kontenmu diindeks dan diurutkan di hasil pencarian.

Melalui artikel ini, kamu akan menemukan strategi-strategi utama yang dapat membantu kamu dalam mengoptimalkan website crawlers dengan lebih baik.

Tidak hanya itu, ada juga tips tambahan yang dirancang untuk memaksimalkan hasil dan meningkatkan visibilitas situs webmu di hasil pencarian. Simak lebih lanjut ya!

Table of Contents

Apa Itu Crawlers Pada Situs Web?

Website crawlers juga dikenal sebagai spider atau spiderbot adalah program yang secara otomatis menjelajahi internet. Tujuannya adalah untuk memeriksa dan mencatat konten dari berbagai halaman web.

Misalnya, Googlebot, yang merupakan website crawlers milik Google, secara teratur mengunjungi situs-situs, mengikuti tautan dari satu halaman ke halaman lainnya, mengumpulkan informasi, dan memprosesnya agar dapat ditampilkan di dalam hasil pencarian Google.

Website crawlers membantu menentukan seberapa baik halaman webmu dapat diindeks dan diberi peringkat. Ini berarti, semakin baik halamanmu dioptimalkan untuk website crawlers, maka akan semakin besar kemungkinan halaman tersebut muncul dalam hasil pencarian dan menarik trafik organik.

Baca juga: Praktikkan 3 Cara Melakukan SERP Analysis Lengkap dengan Tips Menerapkannya

Agar situs webmu mudah ditemukan, penting untuk memastikan bahwa kontenmu dapat diakses dan dipahami dengan baik oleh website crawlers.

Apakah Website Crawlers Ilegal?

Website crawlers atau perayap web, tidak dianggap ilegal secara umum di dalam SEO. Ia adalah alat yang digunakan oleh mesin pencari, seperti Google, untuk mengindeks dan mengurutkan konten di internet.

Tujuan utamanya adalah membantu pengguna menemukan informasi dengan lebih mudah. Namun, legalitas penggunaan website crawlers bergantung pada beberapa faktor ini:

- Banyak situs web memiliki kebijakan di file

robots.txtmereka yang memberikan instruksi tentang bagian mana dari situs yang boleh atau tidak boleh diindeks oleh website crawlers. Mengabaikan kebijakan ini tanpa izin bisa dianggap sebagai pelanggaran. - Jika website crawlers mengakses situs web secara berlebihan, ia dapat mengganggu kinerja situs tersebut, dan ini bisa dianggap sebagai penyalahgunaan.

- Menggunakan website crawlers untuk tujuan yang merugikan, seperti pencurian data atau spamming, jelas ilegal. Tindakan ini termasuk mengumpulkan data secara ilegal atau menyebarkan informasi tanpa izin.

Secara umum, website crawlers yang digunakan sesuai dengan kebijakan situs web dan hukum yang berlaku adalah legal. Selalu penting untuk mematuhi pedoman dan peraturan yang ditetapkan oleh situs web yang kamu akses.

Cara Kerja Website Crawlers

Website crawlers bekerja dengan mengunjungi dan menjelajahi halaman-halaman web di internet secara otomatis. Mereka memulai proses dengan satu atau beberapa URL awal, yang sering kali berasal dari sitemap atau daftar URL yang sudah ada.

Setelah mengakses URL ini, crawler mengunduh konten halaman, termasuk teks, gambar, dan tautan. Konten yang diunduh kemudian dianalisis untuk memahami informasi yang ada dan menentukan relevansi halaman.

Selama analisis, crawler juga mengidentifikasi tautan baru yang ditemukan di halaman tersebut dan menambahkannya ke dalam daftar URL yang akan dikunjungi selanjutnya.

Proses ini berlanjut dengan menjadwalkan dan mengunjungi URL baru, mengunduh halaman, dan menganalisis kontennya, sehingga memperluas cakupan crawling.

Data yang dikumpulkan kemudian diindeks, membuatnya tersedia untuk ditampilkan saat pengguna melakukan pencarian. Selain itu, crawler secara berkala kembali ke halaman yang telah diindeks untuk memeriksa pembaruan atau perubahan, memastikan bahwa indeks tetap akurat dan terbaru.

Melalui berbagai tahapan ini, website crawlers membantu mesin pencari mengumpulkan dan mengatur informasi dari seluruh web, memudahkan pengguna untuk menemukan halaman yang relevan dengan pencarian mereka.

Cara agar Mesin Pencari Dapat Melakukan Crawling

Untuk memastikan mesin pencari dapat menemukan dan mengindeks situs webmu dengan efektif, ada beberapa langkah penting yang perlu dilakukan.

Apalagi proses crawling oleh mesin pencari seperti Google adalah kunci utama agar kontenmu dapat muncul di dalam hasil pencarian.

Dengan menyiapkan situs webmu secara tepat seperti berikut ini, kamu tidak hanya meningkatkan visibilitas online, tetapi juga memastikan bahwa konten yang kamu sajikan mudah diakses oleh pengguna yang mencari informasi relevan.

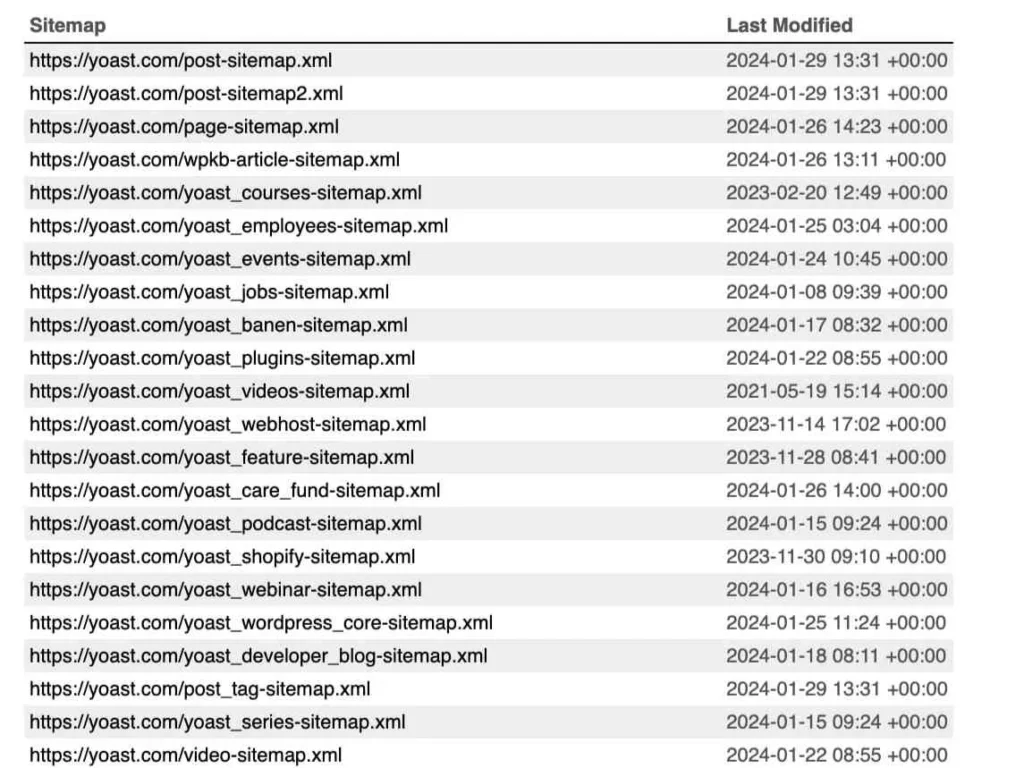

XML Sitemap

XML sitemap adalah file yang berisi daftar URL dari semua halaman penting di situs webmu. Tujuannya untuk membantu mesin pencari, seperti Google, Bing, dan lainnya dalam menemukan dan mengindeks konten situs webmu dengan lebih efisien.

XML sitemap berfungsi sebagai panduan yang memberi tahu mesin pencari tentang struktur situs webmu dan halaman-halaman yang ingin kamu prioritaskan untuk diindeks.

File XML sitemap biasanya dibuat dalam format XML dan dapat mencakup informasi tambahan, seperti tanggal terakhir diperbarui, seberapa sering halaman berubah, dan seberapa penting halaman tersebut dibandingkan dengan halaman lainnya di situs webmu.

Dengan mengirimkan XML sitemap melalui alat seperti Google Search Console, kamu dapat memastikan bahwa mesin pencari memiliki informasi terkini tentang situs webmu, yang dapat mempercepat proses indexing dan membantu halaman-halaman baru atau yang diperbarui muncul dalam hasil pencarian lebih cepat.

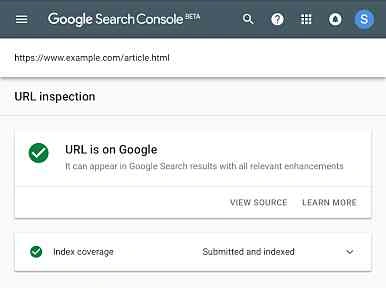

Recrawling Menggunakan URL Inspection Tool

Recrawling menggunakan URL Inspection Tool merupakan proses yang memungkinkan kamu meminta mesin pencari, seperti Google, untuk merayapi ulang halaman tertentu di situs webmu.

Fitur ini tersedia di dalam alat seperti Google Search Console dan sangat berguna ketika kamu telah melakukan pembaruan signifikan pada halaman webmu, seperti perubahan konten atau perbaikan teknis, dan ingin memastikan bahwa perubahan tersebut segera tercermin dalam hasil pencarian.

Untuk menggunakan URL Inspection Tool, kamu cukup memasukkan URL halaman yang ingin kamu periksa ke dalam alat tersebut. Setelah itu, kamu dapat meminta crawling ulang untuk halaman tersebut. Mesin pencari akan menilai halaman yang baru dan memperbarui indeksnya dengan informasi terbaru.

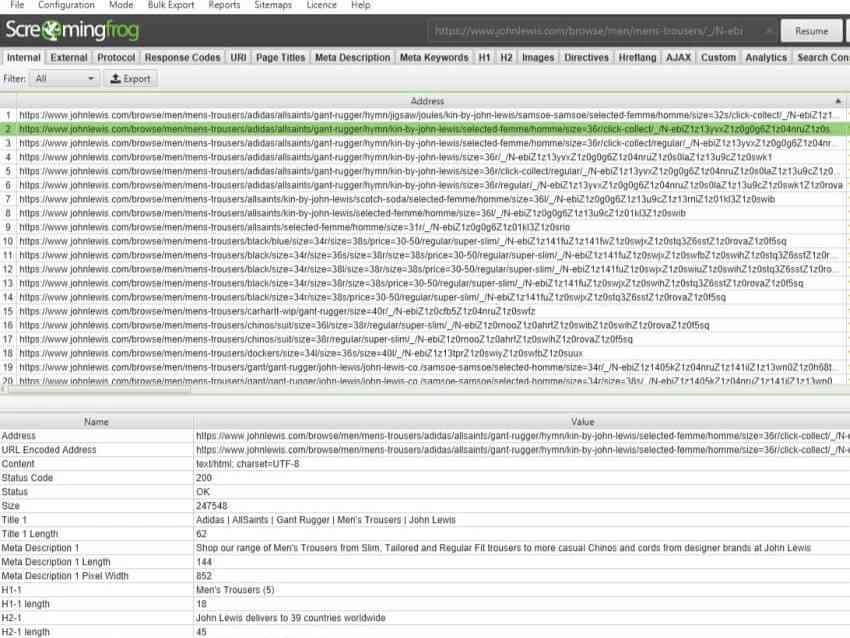

Memanfaatkan Alat Crawling

Alat crawling, seperti Screaming Frog, Sitebulb, atau DeepCrawl dapat memindai seluruh situs webmu dan memberikan laporan mendetail tentang berbagai aspek teknis yang memengaruhi crawling dan indexing.

Melalui alat-alat crawling, kamu dapat mengidentifikasi masalah, seperti tautan rusak, duplikasi konten, kesalahan redirected, dan struktur URL yang tidak optimal.

Alat ini juga dapat menunjukkan halaman yang tidak dapat diakses oleh website crawlers dan masalah dengan file robots.txt atau XML sitemap.

Melalui laporan yang dihasilkan, kamu dapat melakukan perbaikan yang diperlukan untuk meningkatkan kinerja situs web dalam hal crawling dan indexing.

Tips untuk Meningkatkan Kemungkinan Mesin Pencari Melakukan Crawling

Mesin pencari bergantung pada proses crawling untuk menemukan dan mengindeks halaman-halaman baru atau yang diperbarui.

Untuk memastikan situs webmu lebih sering di-crawl oleh mesin pencari, ada beberapa strategi yang bisa kamu terapkan. Di bawah ini kamu akan menemukan beberapa strategi dan tips dalam meningkatkan kemungkinan mesin pencari melakukan crawling.

Tingkatkan Kualitas Situs Web

Kualitas situs web melibatkan beberapa aspek utama, mulai dari struktur teknis hingga konten yang ditawarkan. Ini adalah beberapa tindakan yang bisa kamu terapkan:

- Struktur situs yang terorganisir dengan baik memudahkan website crawlers untuk menemukan dan mengakses halaman-halaman penting. Gunakan hierarki yang logis dengan menu dan internal link yang jelas untuk membantu mesin pencari memahami hubungan antar halaman.

- Halaman yang memuat dengan cepat tidak hanya memberikan pengalaman pengguna yang lebih baik, tetapi juga memungkinkan perayap web untuk menjelajahi lebih banyak halaman dalam waktu yang lebih singkat. Minimalkan waktu muat dengan mengompresi gambar, memanfaatkan caching, dan mengoptimalkan kode.

- Konten yang relevan, informatif, dan unik tidak hanya menarik bagi pengunjung tetapi juga bagi mesin pencari. Gunakan keyword yang tepat, sertakan metadata yang relevan, dan pastikan kontenmu akan mudah dibaca dan dipahami.

- Pastikan bahwa situs webmu bebas dari kesalahan teknis, seperti tautan rusak, redirected yang salah, atau halaman yang tidak dapat diakses. Gunakan alat seperti Google Search Console untuk memantau dan memperbaiki masalah teknis yang dapat menghambat proses perayapan dan pengindeksan.

Segarkan

Mesin pencari seperti Google selalu berusaha menyajikan informasi yang paling akurat dan terbaru agar tetap relevan bagi penggunanya. Dengan memperbarui konten di situs webmu secara teratur, kamu seperti memberi insentif kepada mesin pencari untuk terus mengunjungi kembali situs webmu.

Kamu bisa melihat seberapa cepat Google menangani pembaruan tersebut dengan memeriksa “crawling stat” di Google Search Console.

Di sana, kamu dapat melihat detail tentang perayapan “By purpose,” seperti persentase halaman yang diperbarui dibandingkan dengan halaman baru yang ditemukan. Ini memberimu gambaran seberapa sering kamu berhasil menarik perhatian website crawlers untuk kembali mengunjungi dan mengevaluasi situs webmu.

Baca juga: 3 Langkah Membuat SEO Report untuk Penyajian Data yang Informatif

Perbaiki Struktur Situs Web

Memberikan struktur situs yang terorganisir melalui sitemap yang jelas dan internal link yang tepat akan memudahkan website crawlers untuk beberapa hal ini:

- Menjelajahi situs webmu dengan lebih efisien.

- Memahami susunan halaman dan hierarki konten.

- Mengindeks dan memberikan peringkat pada konten yang paling penting di situs webmu.

Ketika semua ini diterapkan, tidak hanya mesin pencari yang diuntungkan, tetapi juga pengguna. Mereka akan menikmati navigasi yang lebih mudah, yang dapat mengurangi bounce rate dan meningkatkan interaksi mereka dengan situs webmu.

Jika kamu ingin memaksimalkan hasil dari upaya ini dan mendapatkan dukungan ahli atau jasa SEO, Optimaise dapat membantu kamu.

Sebagai penyedia jasa SEO terpercaya, Optimaise menawarkan solusi yang dirancang untuk mengoptimalkan situs webmu secara menyeluruh. Hubungi Optimaise hari ini dan biarkan kami membantu kamu dalam mencapai kesuksesan yang lebih besar!